最新のAI技術「Stable Diffusion」で自分だけの動画を生成したいけれど、

・どのように設定したらうまく動画を生成できるのかわからない… 。

・Stable Diffusionの拡張機能の使い方がわからない… 。

こんな悩みを持っている方は多いのではないでしょうか?

そこでこの記事では 、

・Stable Diffusionとその拡張機能「mov2mov」の基本的な使い方

・動画生成のための効果的な設定方法

を詳しく解説します。Stable Diffusionで動画作成にチャレンジしたい人は、ぜひ参考にしてください。

公開日:2023年9月28日

\文字より動画で学びたいあなたへ/

Udemyで講座を探す >INDEX

Stable Diffusionの拡張機能「mov2mov」について知ろう

Stable Diffusionの魅力的な拡張機能「mov2mov」を既にご存知ですか?mov2movは、元となる動画をフレームごとにAIに解析させ、それぞれの画像をAIが再解釈した結果を動画として出力します。

mov2movを活用することで、一般的な動画を一瞬で斬新なAI動画に変換することが可能になります。ただし、生成した動画をSNSなどで公開する際には注意が必要です。

著作権法に抵触する可能性がありますので、自分自身を主体としたオリジナルの動画を使用するか、または明確に著作権フリーと記載されている素材を使用しましょう。

利用時に大切なのは、AIの力を用いて、自分だけの創造的な表現を試みることです。

以下、「mov2mov」を使ったAI動画生成の流れをご紹介します。

- 元となる動画を用意

- mov2movを用いて動画をAI画像に変換

- 出力されたAI画像を再度動画として編集

上記のステップを順に進めていくことで、オリジナルAI動画を作り出すことができます。

\文字より動画で学びたいあなたへ/

Udemyで講座を探す >Stable Diffusionにmov2movを導入する方法

Stable Diffusionとmov2movを一緒に使うためには、まずControlNetのインストールと設定が必要となります。ControlNetとは、mov2movが動作するための前提条件となるものです。

ControlNetのインストールと設定を行う

ControlNetは、Stable Diffusionの拡張機能として機能します。インストール手順は、以下のとおりです。

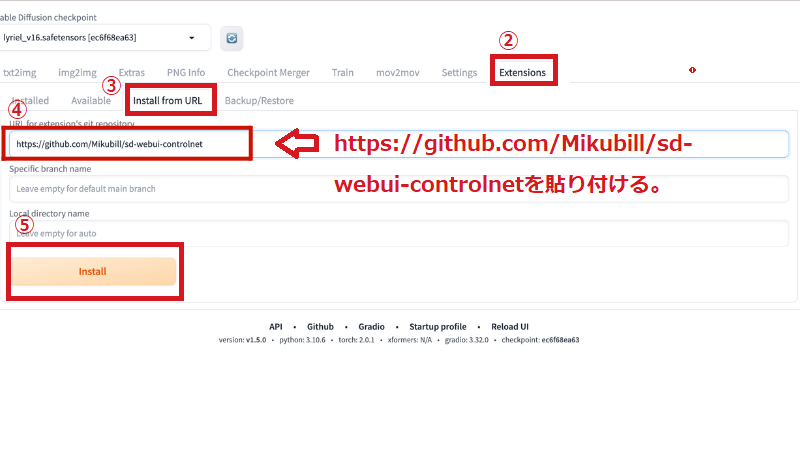

①Stable DiffusionのUI操作画面を開きます。

②「Extension」メニューを開きます。

③「Install from URL」を選択します。

④URL for extension’s git repositoryに「https://github.com/Mikubill/sd-webui-controlnet」を貼り付けます。

⑤「Install」ボタンを押してインストールを開始します。

ControlNetがインストールされたら、次はControlNetのモデルをインストールします。ここでいう「モデル」とは、AIや機械学習の文脈において、データから学習した結果の構造やパラメータの集合を指します。簡単にいえば、AIの「知識」や「経験」のようなものです。これにより、AIは特定のタスクを効率的に実行することができます。また、複数のControlNetモデルを併用するための設定も必要です。

ControlNetのモデルに関しては「Hugging Face(ハギング・フェイス)」からダウンロード可能です。

気になるモデルがダウンロード完了したら、Stable Diffusionがインストールされているフォルダの「models」の下にある「ControlNet」に格納しましょう。

mov2movをインストールする

次に、ControlNetと同じ手順でmov2movをインストールします。以下に具体的な手順をリストアップします。

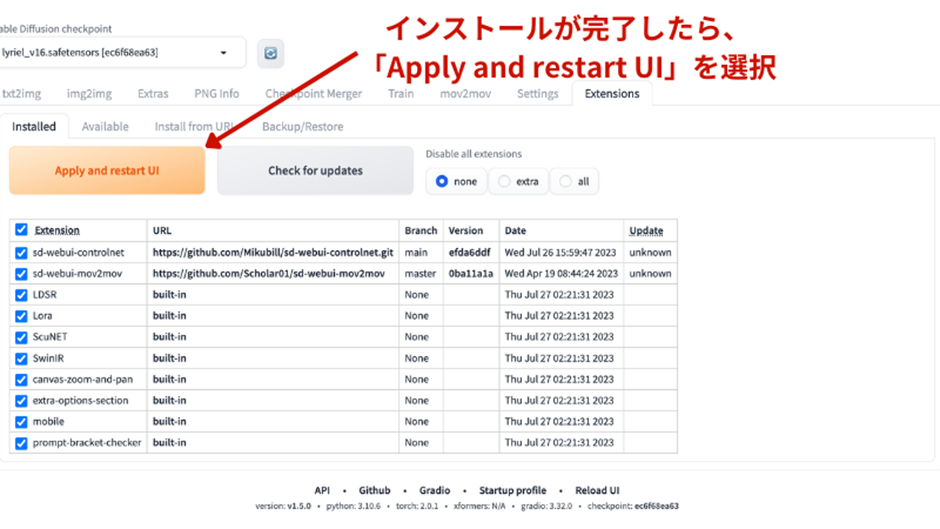

- Stable DiffusionのUI操作画面を開き、「Extension」から「Install from URL」を選択します。

- URL for extension’s git repositoryに「https://github.com/Scholar01/sd-webui-mov2mov」を入力し、「Install」ボタンを押します。

- インストールが完了したら、Installedタブから「Apply and restart UI」ボタンを押し、新たにインストールしたmov2movを有効にします。

mov2movの初期設定を行う

インストールしたら、mov2movの初期設定を行います。ControlNetを操作できるようにする、重要なステップです。以下に設定手順をご紹介します。

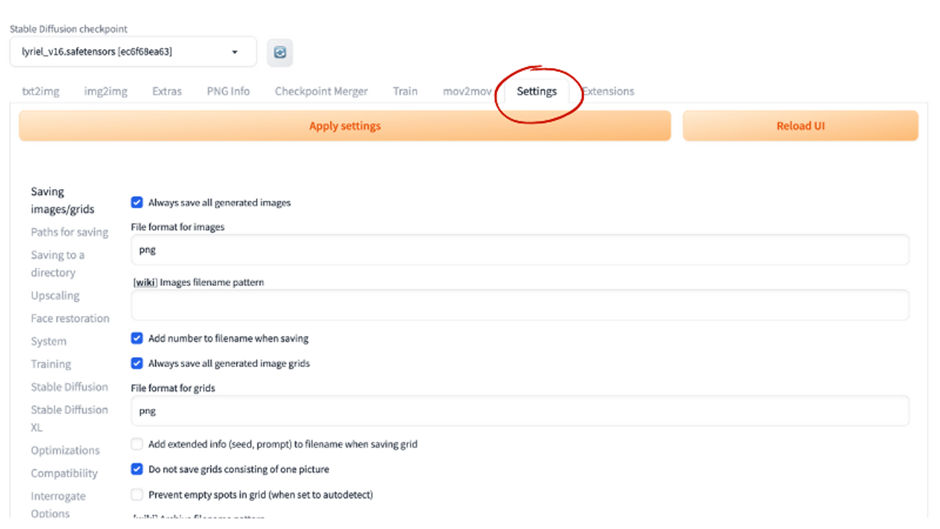

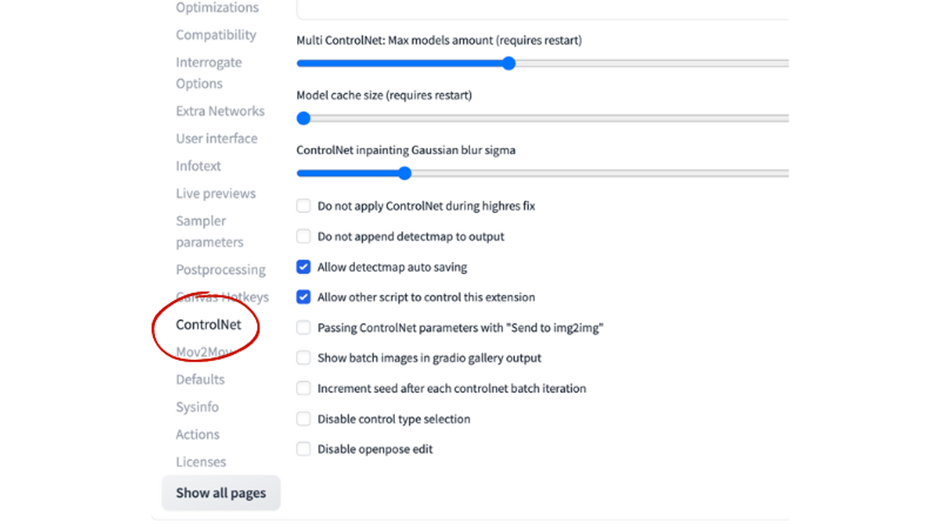

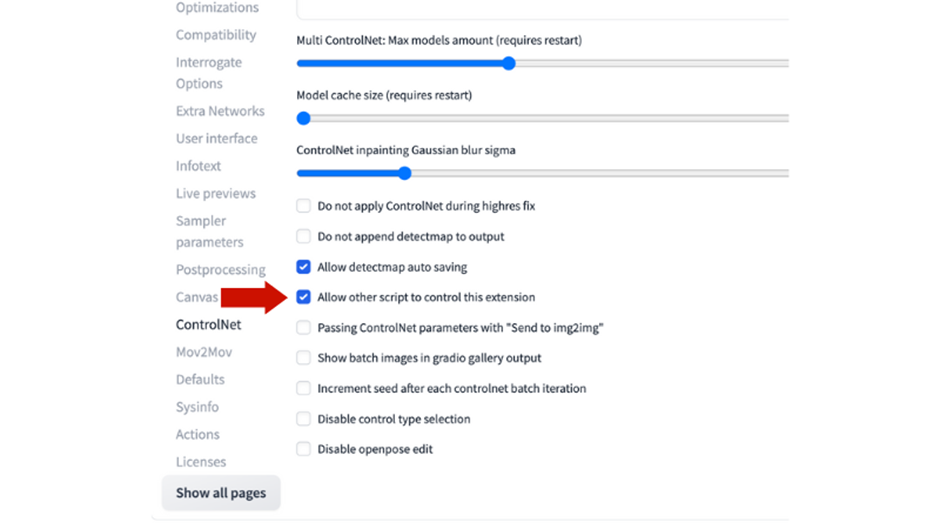

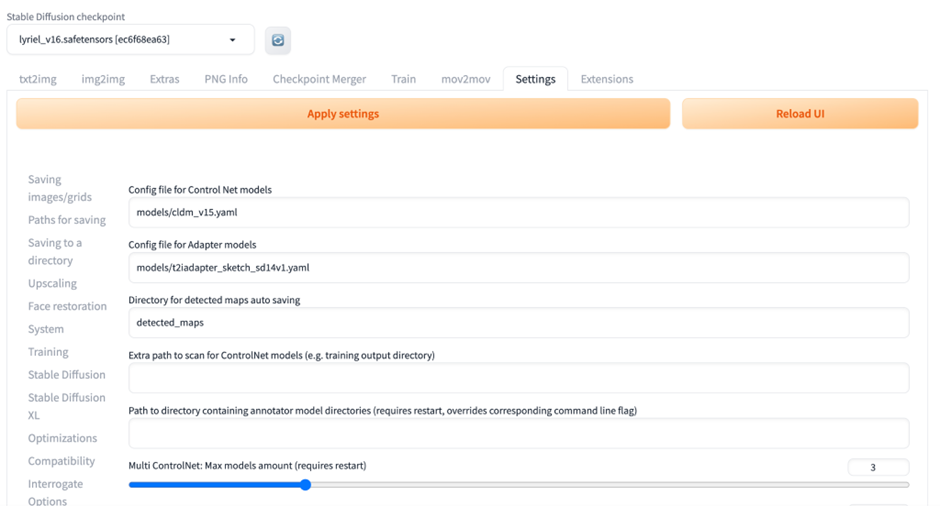

「Settings」タブを開き、ControlNetの設定画面へ移動します。

「Allow other script to control this extension」オプションにチェックを入れます。

設定を完了したら「Apply settings」を押し、その後「Reload UI」を押して設定を適用します。

以上の手順で、mov2movがStable Diffusionに導入され、初期設定が完了します。

【Stable Diffusion】mov2movの使い方

ここでは、プロンプトの入力方法、設定の調整方法、そしてモデルの選択と動画生成の手順を順に解説します。

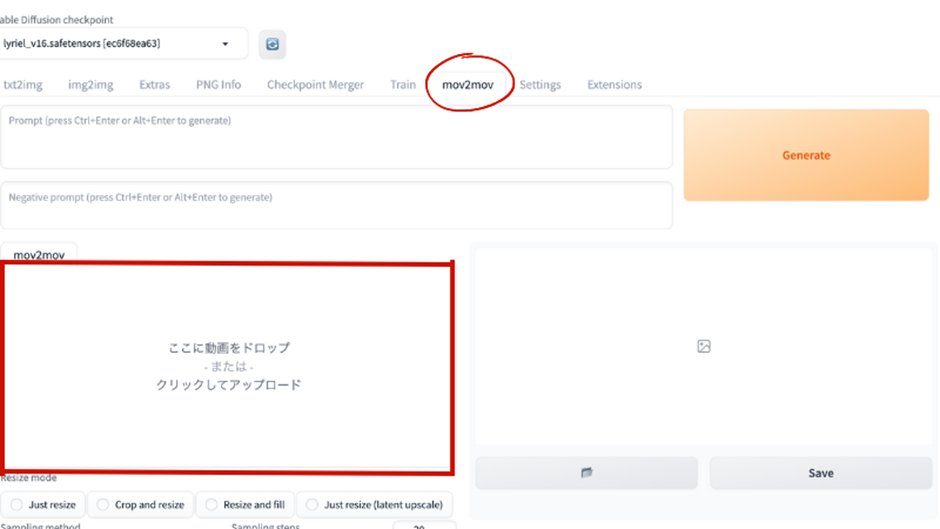

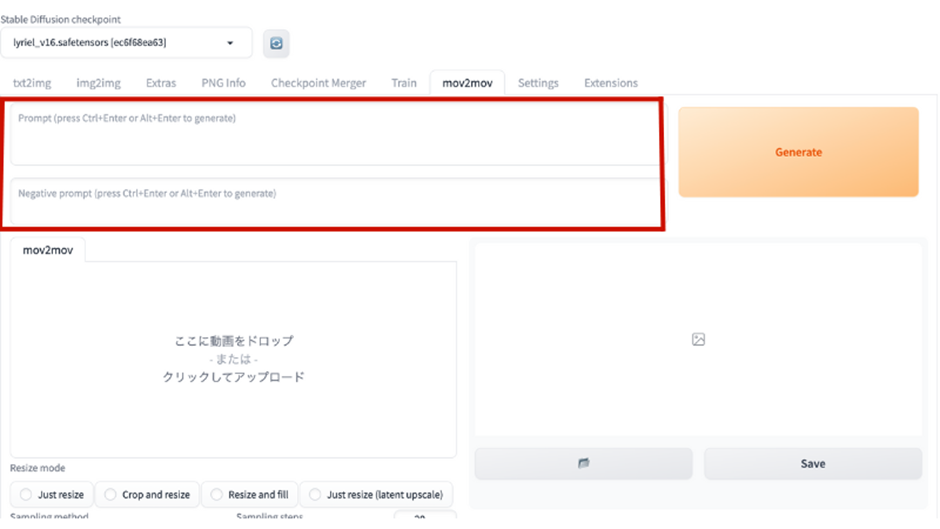

プロンプトを入力する

mov2movの動画生成では、プロンプトの設定が重要です。これにより、自分のイメージ通りのAI動画を生成することができます。

特に生成が初めての場合や、特に希望がない場合は、qualityタグのみで進めてみると良いでしょう。

設定を調整する

設定の調整も、高品質な動画を生成するために重要です。

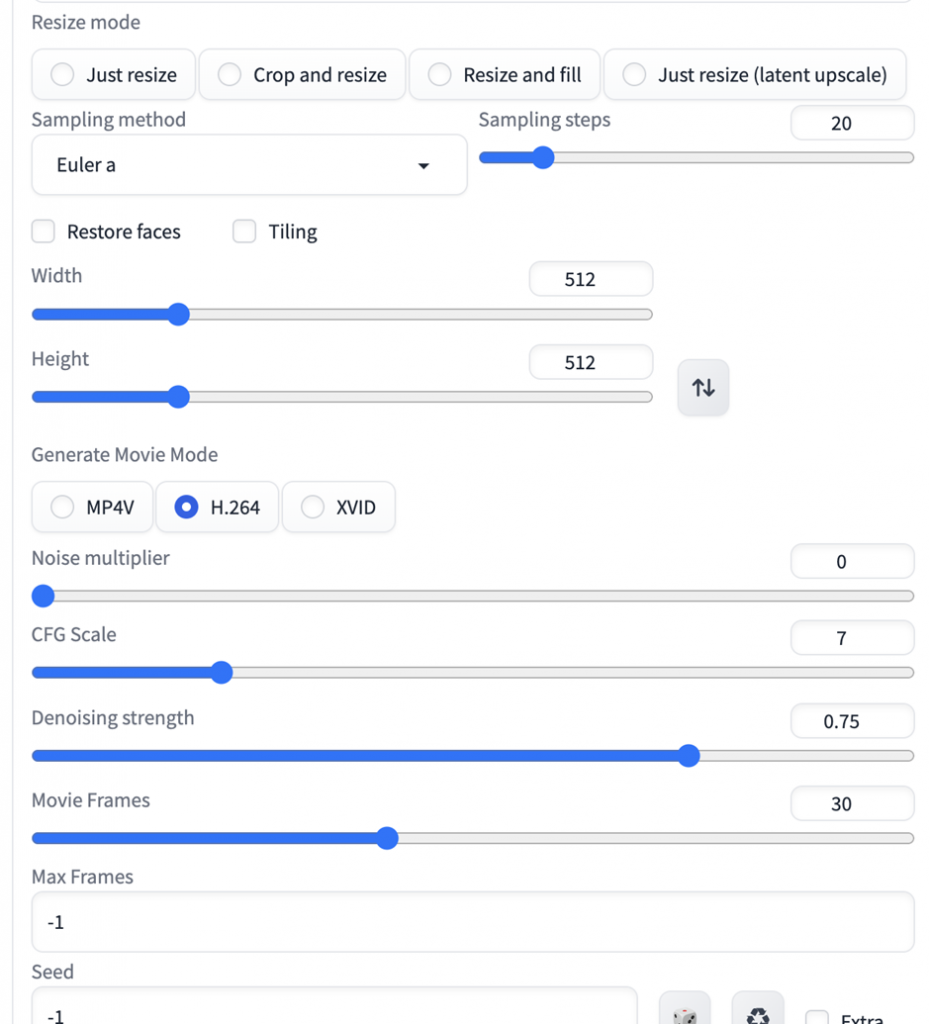

「Resize mode」で動画の縦横比などのサイズ変更、「Steps」でノイズを除去する回数、「Sampling method」でそのアルゴリズムを選ぶことができます。

初めての場合は、「Generate Movie Mode」をMP4Vにして、「Denoising strength」を0.7、「Movie Frames」を25に設定し、他は初期設定のままで生成してみると良いでしょう。

モデルを選択し動画を生成する

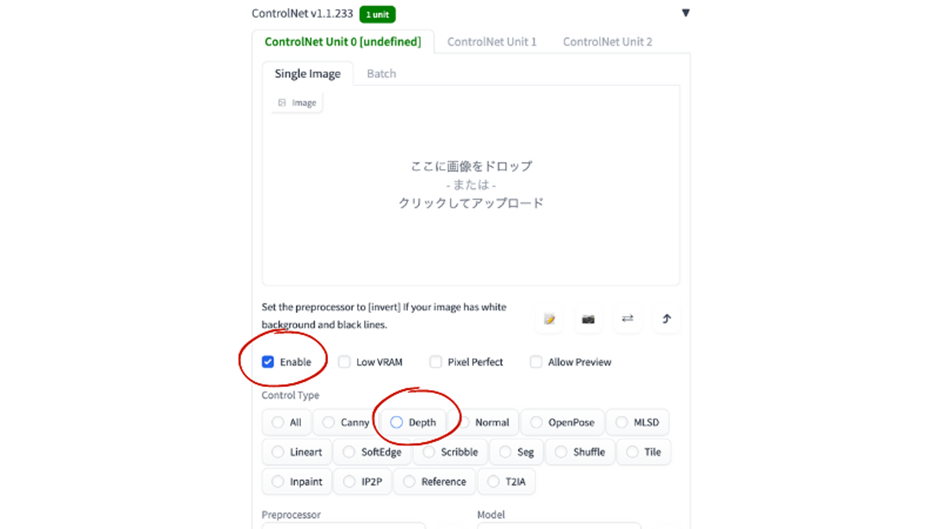

最後に、ControlNetのモデルを選択します。モデルの設定は、生成する動画の出来を大きく左右します。

まずは「Enable」をチェックし、「Depth」を選択し、動画をアップロードしてみましょう。生成にはかなりの時間がかかるため、5秒以下の短い動画で試すことをおすすめします。

Stable Diffusionでより良い動画を生成するコツを3つ紹介!

Stable Diffusionを使って動画を生成する際、押さえておくべきポイントやコツがいくつかあります。これらを理解し適用することで、生成される動画が格段に良くなったり、自分のイメージ通りの動画になりやすくなります。以下ではその3つのコツを具体的に紹介します。

プロンプトを詳しく設定して自分のイメージに近づける

プロンプトを詳しく設定しなくても動画を作ることはできますが、細かく指示を設定しておくことで自分のイメージ通りの動画が作りやすくなります。例えば、人が踊っている動画に対して髪色や年齢、性別などのキャラクター像をプロンプトに設定することで、そのキャラクターが踊っているような動画を生成することも可能です。

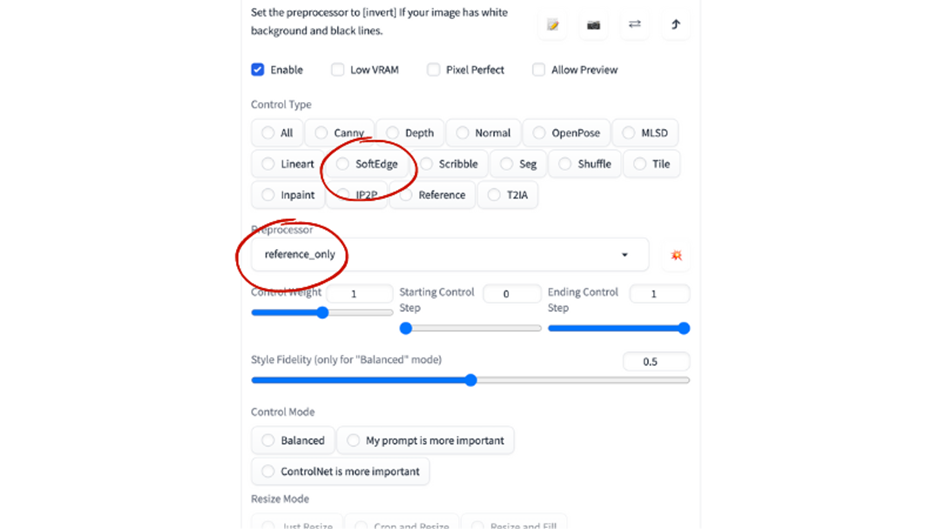

一貫性を補う「reference only」を活用する

ControlNetの特性上、フレーム間の連続性が確保されにくい場合がありますが、そこで「reference only」機能が役立ちます。この機能を使用することで、連続する画像の雰囲気が似るようになり、キャラクターや背景の一貫性が保たれます。 また「soft edge」を併せて利用することで、元の動画の人や背景を忠実に再現し、より自然なAI動画を作ることができます。

グラフィックボードを見直し生成速度を上げる

AIイラストの生成には、グラフィックボードのスペックが大きく影響してきます。AI動画はフレームごとにAIイラストへの変換を行うのでその影響を如実に受けることになります。 もし今後本格的にAI動画を作っていくのなら、ハイスペックなグラフィックボードの購入を検討してみてください。

まとめ

Stable Diffusionを使った、プロンプトを入力することで動画を作成することが可能です。Stable Diffusionとmov2movを使いこなすための基本的な手法を学び、AI動画生成の第一歩を踏み出してみましょう。

Stable Diffusionを使った動画作成を学びたい人には、下記の講座がおすすめです。

画像生成系AI「Stable Diffusion」の使い方や画像生成のテクニックをPythonやAPIを使って学ぼう!

StableDiffusionをHaggingFace、DreamStudio、StableStudio、Fooocusなどを使って動かしてみよう!PythonでAPIを叩いて動かしてみよう!画像生成のテクニックを知ろう!

\無料でプレビューをチェック!/

講座を見てみる評価:★★★★★

色々勉強しようと思い、受講しました。何回も再生して理解を深めようと思います。

Stable Diffusionの拡張機能を活用してオリジナル動画を作成しましょう!

最新情報・キャンペーン情報発信中