RAGという用語を見聞きしたものの、

・LLMとの関係性が分からない…。

・RAGを使うメリットが知りたい…。

という方も多いのではないでしょうか。そこでこの記事では、

・RAGの仕組みやLLMの違い

・ビジネスでのRAGの活用例

についてご紹介します。

初心者の方でも、この記事を読めば、RAGやLLMの役割について理解できます。

\文字より動画で学びたいあなたへ/

Udemyで講座を探す >RAGとは?

RAG(ラグ)とは「Retrieval Augmented Generation(検索拡張生成)」の略称で、生成AIをサポートする技術の一種です。ユーザーからの質問や指示に対して、外部のデータから情報を検索して回答を生成する仕組みがRAGと呼ばれます。

RAGを導入すると、ユーザーが自ら情報を探す手間を省けるため、ビジネスの効率化に役立つツールとして注目を集めています。

\文字より動画で学びたいあなたへ/

Udemyで講座を探す >RAGとLLMの違いと関係性

LLMは「Large Language Models(大規模言語モデル)」の略称で、対話型AIに搭載されている仕組みです。RAGとLLMは別の仕組みで、RAGを使用するとLLMの欠点を補えます。

LLMとは?

LLMには膨大なテキストデータが含まれており、LLMを搭載した対話型AIはユーザーとの自然な対話が可能です。LLMでは、ユーザーが入力した文字を名詞や接続詞などに細かく区切り、前後の関連性を計算するといった処理が行われます。

LLMの詳細については、「大規模言語モデル(LLM)とは?仕組み・活用例・課題を解説!」で詳しく解説しているので、併せてご覧ください。

代表的なLLMは、ChatGPTに搭載されているGPT-3やGPT-4、GoogleのBERTなどです。

LLMが活用されている対話型AIのChatGPTやBardについては、下記の記事をご覧ください。

◆BERTとは何か?Googleが誇る最先端技術の仕組みを解説!

◆対話型AI「ChatGPT」と「Bard」の違いは?特徴や性能を解説!

LLMの問題点

LLMを搭載した生成AIを利用する際は、セキュリティ上の問題点に注意が必要です。ユーザーが入力した情報を学習用のデータとして用いる生成AIでは、個人情報や企業の機密情報などを入力すると情報漏洩につながるリスクがあります。

また、LLMによって生成される回答は必ずしも正しいとは限りません。誤った情報が生成される「ハルシネーション」という現象が起こる場合もあります。

そのため、生成AIが出力した情報はそのまま鵜呑みにせず、ユーザー(人間が)が真偽を確かめることが重要です。

RAGの仕組み

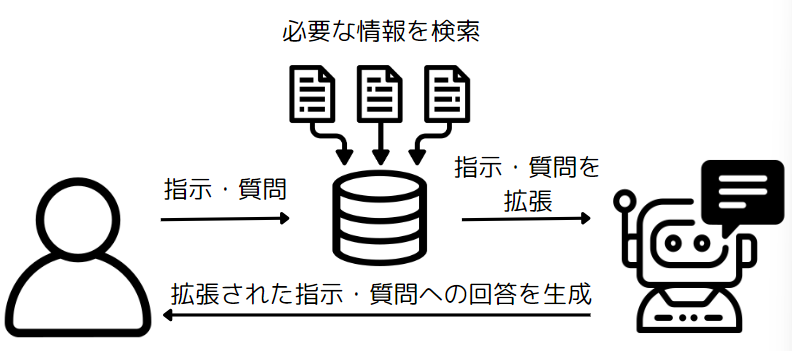

RAGと生成AIを組み合わせると、RAGが回答に必要な情報を外部のデータベースから抽出し指示や質問を拡張するため、生成AIが出力する回答の精度を高められます。

RAGの基本的な仕組みは以下の通りです。

①必要な情報を検索する

まずは、ユーザーが入力した指示や質問をもとに、回答に必要なデータを外部のデータベースから検索します。RAGで参照できるデータの種類は、文章や画像、PDFファイルなど様々です。

ただし、指示や質問の内容によっては、必要なデータをうまく検索できない場合もあります。回答の精度を高めるためには、可能な限り具体的な指示や質問を入力することが重要です。

②情報をもとに指示・質問を拡張する

次に、データベースを検索して得られた情報を、ユーザーが最初に入力した指示や質問に追加し拡張します。拡張してから生成AIに伝えることで、より適切な回答を得やすくなります。

③拡張した指示・質問に対して答えを生成する

最後に、拡張された指示や質問に対する回答をAIが生成し、ユーザーに対して表示します。

RAGとファインチューニングの違い

RAGと似た技術に「ファインチューニング」があります。ファインチューニングとは、AIモデルに独自のデータを追加学習させ、特定の分野に対してより詳しく新たな知識を蓄えたLLMにする技術です。

RAGとファインチューニングの違いは、AIモデルに学習させるかどうかです。ファインチューニングは、質問する度に独自のデータベースを追加学習するため、特定の分野に特化したAIモデルにカスタマイズできます。

一方、RAGはデータベースの内容を学習しないため、AIモデルの知識が偏ったり特定の分野に特化したりしません。ユーザーが質問する度に、データベースを検索し、回答を出力します。

RAGとファインチューニングどちらにもメリット・デメリットがあるため、目的に合わせた仕組みを活用しましょう。

RAGのメリット

RAGを活用すると、生成AIの精度が高まることや、情報のソースが分かることなどいくつかのメリットが得られます。主なメリットは次の通りです。

ハルシネーションの生成を低減できる

ハルシネーションとは、AIが誤った情報や事実と異なる情報を生成してしまう現象です。RAGを使用すると、回答の精度が高まるため、単にプロンプトを入力して回答を得る場合と比べて、ハルシネーションが起きるリスクを低減できます。

RAGを使用し、ハルシネーションのリスクを低減することで、情報の真偽を確認する時間が節約できます。

なお、RAGのように、外部のデータなどをもとにしてより正確な回答を生成する手法は、ファインチューニングと呼ばれます。

情報のソースが分かる

自社で用意した外部データをRAGで読み込ませる場合、生成AIが使用した情報のソースが明らかであることがメリットです。根拠のあるデータをもとに回答が生成されるため、ファクトチェックがしやすくなります。

情報の更新が容易

LLMを搭載した生成AIに新たなデータを学習させたい場合、AIのモデル自体を再構築する手間がかかります。

一方、RAGであれば外部のデータベースを編集するだけで学習元の情報の更新が可能です。最新のデータをもとにした回答を簡単に生成できることがRAGのメリットです。

RAGの活用例

RAGはビジネスの様々な場面で役立ちます。RAGの主な活用例は次の通りです。

社内Q&A

社内のデータベースや、Q&Aが書かれたドキュメントをRAGで読み込むと、社内のQ&Aシステムを構築できます。

通常の生成AIは主にインターネット上の情報を元に回答を出力するため、詳細なプロンプトを入力しない限り汎用的な回答が多くなります。

一方、RAGを組み込んだ生成AIを使用すると、RAGが社内のデータベースや独自のドキュメントを検索対象とし回答のサポートをするため、汎用的な回答ではなく、社内規定などに沿った精度の高い独自の回答が出力可能になります。

問い合わせチャットボット

RAGは、お客様からの問い合わせに自動で答えるチャットボットの作成にも役立ちます。

チャットボットは、RAGを組み込まなくても作成可能ですが、自社サービスや商品の情報を生成AIに学習させるには時間や手間がかかります。

RAGを組み込み、自社の提供するサービスや商品の特性といった情報を読み込ませることで、手間が削減でき、チャットボットの回答精度も高まります。

さらに、ユーザー(企業側)が指定し、読み込ませたデータベースを基に回答を出力しているため、より詳しい情報を知りたい利用者(お客様)に対して、参照元を提示することもできます。

RAGを使って業務を効率化させよう

RAGとは生成AIなどに活用される仕組みで、LLMの欠点を補うことが可能です。RAGによって外部の情報を学習させることで、生成AIの回答精度の向上が期待できます。

社内Q&Aやチャットボットなどを開発する際は、ぜひRAGを活用しましょう。

RAGを実装する具体的な方法を学びたい方には、以下の講座がおすすめです。

【初心者向け】大規模言語モデルにおけるRAGを実装できるようになろう!Webページの情報を元に回答できるAIを作ろう!

大規模言語モデルを活用する上で非常に重要なアプローチであるRAGについて学び実装していきます!特定のWebページの情報を元に回答してくれるAIを作っていきますよ!

\無料でプレビューをチェック!/

講座を見てみるレビューの一部をご紹介

評価:★★★★★

コメント:RAGとはどういったものなのかを実感できる貴重なコースでした。各々のコードの意味についても丁寧に説明いただけたのでなんとかついていくことができました。

評価:★★★★★

コメント:要素を一つずつ丁寧に説明されていて理解しやすかったです。また、LLMの技術動向解説も分かりやすくて良かったです。

RAGを実装し、回答精度の高いAIを作成してみましょう!

最新情報・キャンペーン情報発信中