AIに関連する技術に興味があるものの、

・TransformerやAttentionという用語の意味が分からない…。

・詳しい仕組みや活用方法が知りたい…。

という方も多いのではないでしょうか。そこでこの記事では、

・TransformerとAttentionの機能や関係性

・Attentionが活用される具体的なタスク

についてご紹介します。

公開日: 2024年2月2日

\文字より動画で学びたいあなたへ/

Udemyで講座を探す > 監修

監修

専門領域:人工知能(AI) / 生成AI / ディープラーニング / 機械学習

我妻 幸長 Yukinaga Azuma

「ヒトとAIの共生」がミッションの会社、SAI-Lab株式会社の代表取締役。AIの教育/研究/アート。東北大学大学院理学研究科、物理学専攻修了。博士(理学)。法政大学デザイン工学部兼任講師。オンライン教育プラットフォームUdemyで、十数万人にAIを教える人気講師。複数の有名企業でAI技術を指導。「AGI福岡」「自由研究室 AIRS-Lab」を主宰。著書に、「はじめてのディープラーニング」「はじめてのディープラーニング2」(SBクリエイティブ)、「Pythonで動かして学ぶ!あたらしい数学の教科書」「あたらしい脳科学と人工知能の教科書」「Google Colaboratoryで学ぶ! あたらしい人工知能技術の教科書」「PyTorchで作る!深層学習モデル・AI アプリ開発入門」「BERT実践入門」「生成AIプロンプトエンジニアリング入門」(翔泳社)。共著に「No.1スクール講師陣による 世界一受けたいiPhoneアプリ開発の授業」(技術評論社)。

…続きを読むINDEX

Attention機構とは

Attention機構とは、AIが深層学習によってモデルを構築する際に重要な役割を果たす仕組みです。畳み込みニューラルネットワーク(CNN)や再帰型ニューラルネットワーク(RNN)などと並ぶ画期的なアーキテクチャで、自然言語処理などに利用されています。

Attention機構は『Attention Is All You Need』という論文の中で、Transformerという新たなニューラルネットワークの仕組みを支える技術として紹介されました。Attentionと呼ばれる仕組みにより、AIがタスクを完了するためにどの単語が重要であるかに注意を向けることが可能です。

Attentionを用いた手法により、学習対象が長文になると精度が下がるという従来の学習モデルの欠点が克服されました。

CNNやRNNの意味や仕組み、性能の違いについては下記の記事を参考にしてください。

◆ニューラルネットワークとは?人工知能の基本を初心者向けに解説!

◆畳み込みニューラルネットワークとは?手順も丁寧に解説

\文字より動画で学びたいあなたへ/

Udemyで講座を探す >TransformerとAttention

Transformerは、Attention機構の仕組みを活用して作られた学習モデルです。ここでは、TransformerとAttention機構の関連性や基本的な仕組みについて解説します。

Attention機構を取り入れて作られた「Transformer」

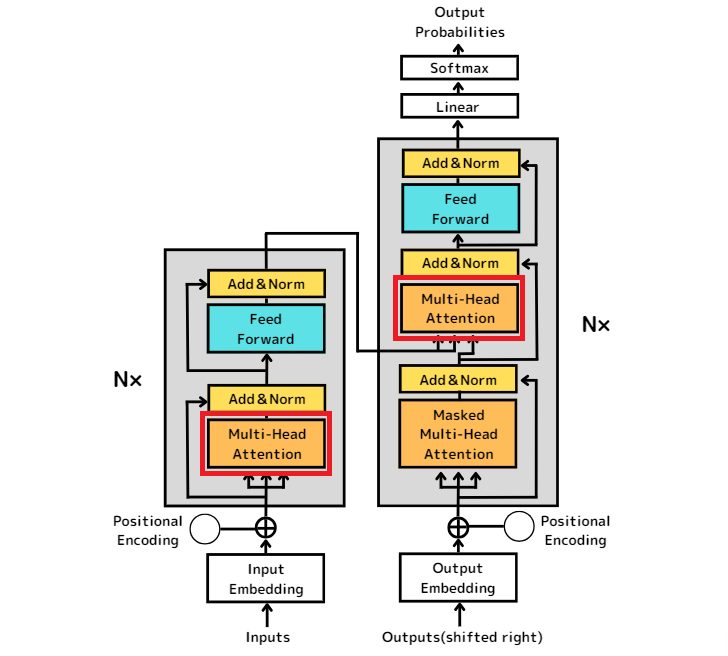

Transformerは、エンコーダとデコーダと呼ばれる2つの構造を持つ深層学習モデルです。各部分には重要なデータに注意を向けるためのAttention機構が含まれます。Transformerでは、文章などの情報をベクトルデータとして入力・出力することで高精度な自然言語処理が可能です。

Transformerが解説された論文の内容や、関連する用語などについては下記の記事を参考にしてください。

◆Transformerとは?AI機械学習の仕組みを解説

Multi-head Attentionを利用

Transformerには、Attention機構を発展させた「Multi-head Attention」という仕組みが含まれます。

同時に複数の重要箇所に注目し、文章の意味などをより高精度に認識できることがMulti-head Attentionの特徴です。また、複数のAttentionを利用することでデータの並列処理が可能となり、データの入出力のスピードも向上しました。

従来手法の欠点を克服したAttention

Attentionは、RNNやCNNなどのニューラルネットワークには含まれていなかった仕組みです。ここでは、Attentionと従来型のネットワークの関係性について解説します。

RNN(リカレントニューラルネットワーク)との関係

RNN(Recurrent Neural Network)は、音声やテキストといった連続的な値を持つ系列データや時系列データの処理に用いられているニューラルネットワークです。RNNの手法には、長時間の音声や長文を対象とした学習で精度が下がってしまうという技術的な欠点がありました。

しかし、このRNNの欠点は、Attention機構と組み合わせて使うことで解決します。Attention機構によりデータの重要な箇所に注目して学習を行われ、長期の時系列データや長文のテキストデータでも高い精度で学習できるようになるからです。

CNN(畳み込みニューラルネットワーク)との関係

CNN(Convolutional Neural Network)は、画像データを分析し、物体や表情などを認識するタスクに用いられるニューラルネットワークです。CNNに含まれる畳み込み層と呼ばれる技術により、画像内の隣接するピクセル同士の関係性を捉え、表示されている内容を認識できます。

ただし、背景に表示されているものなど、認識したい対象以外の要素から影響を受けてしまうことがCNNの欠点です。

このCNNの欠点も、Attentionで画像内の注目すべき範囲を特定することにより、認識精度の向上が可能になるため、Attention機構と組み合わせることによって解決されます。

各タスクでのAttentionの役割

Attentionは、画像認識や機械翻訳などのタスクで活用されています。各タスクにおけるAttention機構の役割は次の通りです。

画像認識におけるAttention(Vision Transformer)

画像認識のタスクでは、Attentionを含む「Vision Transformer」という技術が利用されます。Vision TransformerはViTとも呼ばれます。ViTでは、画像内のどの領域に対して、どれだけ注目するかを可視化することが可能です。

従来は、画像認識のタスクにはCNNが多く用いられていましたが、Attention機構を用いたVision Transformerが登場したことで性能が上がり、より高精度に画像分類タスクを実行できるようになりました。

機械翻訳におけるAttention(Transformer)

機械翻訳のタスクには、Attention機構を含むTransformerが利用されています。従来のモデルにあったRNNを含まず、Attentionの仕組みのみで学習を行う点がTransformerの特徴です。Transformerの仕組みを使うと、従来のニューラルネットワークよりも高速かつ高精度で処理を行えます。

Transformerは、文章をベクトルデータに変換した上で、意味の理解や新たな文章の生成などを行える技術です。そのため、機械翻訳だけでなく、要約や文章作成など幅広い自然言語処理タスクに活用されています。

自然言語処理について詳しくは「自然言語処理とは?スマートスピーカーにも使われている技術をわかりやすく解説!」をご覧ください。

AttentionとTransformerの機能を理解して、AIの利用や開発に役立てましょう!

Attention機構は、ニューラルネットワークのTransformerを構築する重要な仕組みです。AttentionをRNNやCNNと組み合わせて活用することで、従来型のニューラルネットワークの欠点を克服できます。

Transformerの仕組みを学び、プログラミング言語を用いてTransformerを実装してみたい方には、下記の講座がおすすめです。

Transformerを詳しく学ぼう! -PyTorchで実装するAttention、Transformer-

生成AI、大規模言語モデル(LLM)のベースとなる技術、「Transformer」について詳しく学ぶ講座です。Python、PyTorchを使って必要なユニットを順を追って実装し、最終的にTransformerを組み立てます。

\無料でプレビューをチェック!/

講座を見てみる評価:★★★★★

コメント:吾妻講師の講座は色々と拝聴しています。解り安いので助かります。

評価:★★★★★

コメント:pythonの勉強として利用しました。生成AI、大規模言語モデル(LLM)の詳細がよくわからなかったので、少しでも理解できて良かったです。

Transformerを詳しく学び、生成AIに対する深い洞察力を身につけましょう!

最新情報・キャンペーン情報発信中